前言:

此文接的是上篇,上次的内容是,用python操作elasticsearch存储,实现数据的插入和查询。 估计有些人一看我的标题,以为肯定是 logstash kibana elasticsearch的组合。这三个家伙也确实总是勾搭在一块。 其实logstash是可以被别的替换,比如常见的fluented 。剩下的那两个,kibana和elasticsearch是一伙的,不好做分离。

这次用的不是那种开源的、cs模式日志收集应用,还真不是。而是自己直接从程序里面把日志打到elasticsearch里面(可以是python,也可以用shell的curl)。然后通过kibana把elasticsearch数据读出来,直接绘图。

我个人还是不喜欢用elasticsearch做存储,他的一些语法说明不够犀利,主要原因还是他的DSL让我头疼。 我还是喜欢把结果打到mongodb里面。 对于我来说mongodb的查询语句是我很喜欢的。

不扯了,开始切入主题。 我这里的想法比较简单和方便,比如需要监控一些数据,我们完全可以把结果打到elasticsearch里面。 而不是我前面说的那样,还需要从库里面取出数值,然后再用前端画图,另外数据的接口还不好控制,真心是麻烦,当然对于熟练前后端的人来说,这也仅仅是麻烦而已。

下图是我以前的一个项目,通知平台的前端,当时开发的时候,真是十分的蛋疼,一会搞数据层,一会搞前端的ajax模板,但是带来的好处也不少,尤其是提高自己的前后端细节的写码能力。

但说起来,感觉如果用kibana3的话,在一定程度来说,很是方便。 只需要给elasticsearch下面的数据格式就行了。

index是索引,在elasticsearch里面,一切皆索引(我说的)

type是格式,咱们做图表的时候,基本是根据type做归类的。比如,web相关的为一个索引,然后nginx和varnish为不同的type。 当然也可以再细化,把那个nginx服务都可以做一个索引。 只要你不觉得乱套就行了。 很多人担心elasticsearch的大数据能力,其实我没怎么把他看做大数据处理,就把他做个临时一个月的存储,做一些个日志分析,监控啥的。 (个人喜欢)

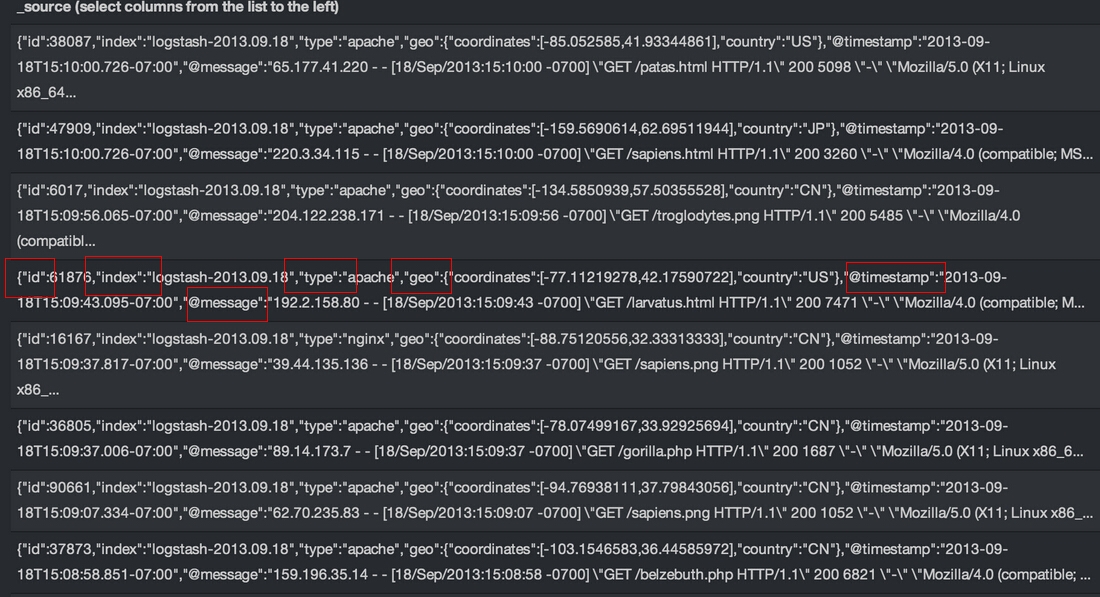

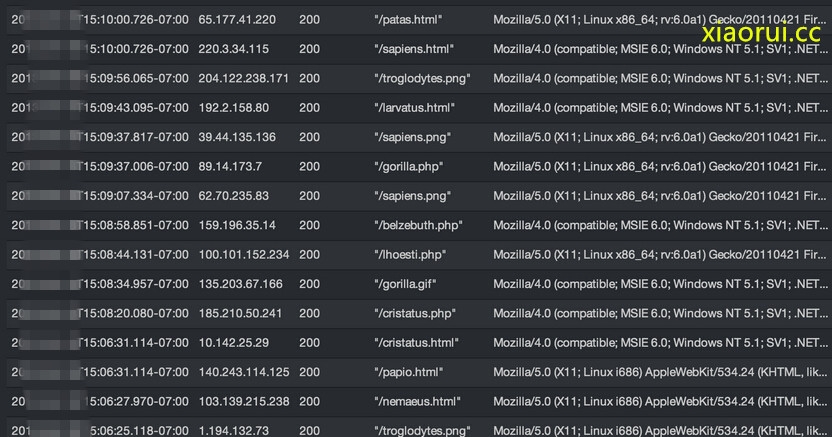

@message 是主数据内容

@timestamp是时间,kibana默认是根据这个来做时间段的。

上面的数据有些乱,咱们可以把键值对分化的更细致点。

原文:http://rfyiamcool.blog.51cto.com/1030776/1421049

但是kibana3二次开发起来,对于初学者来说,是有难度的。

万恶的爬虫,这里注释下原文地址,blog.xiaorui.cc

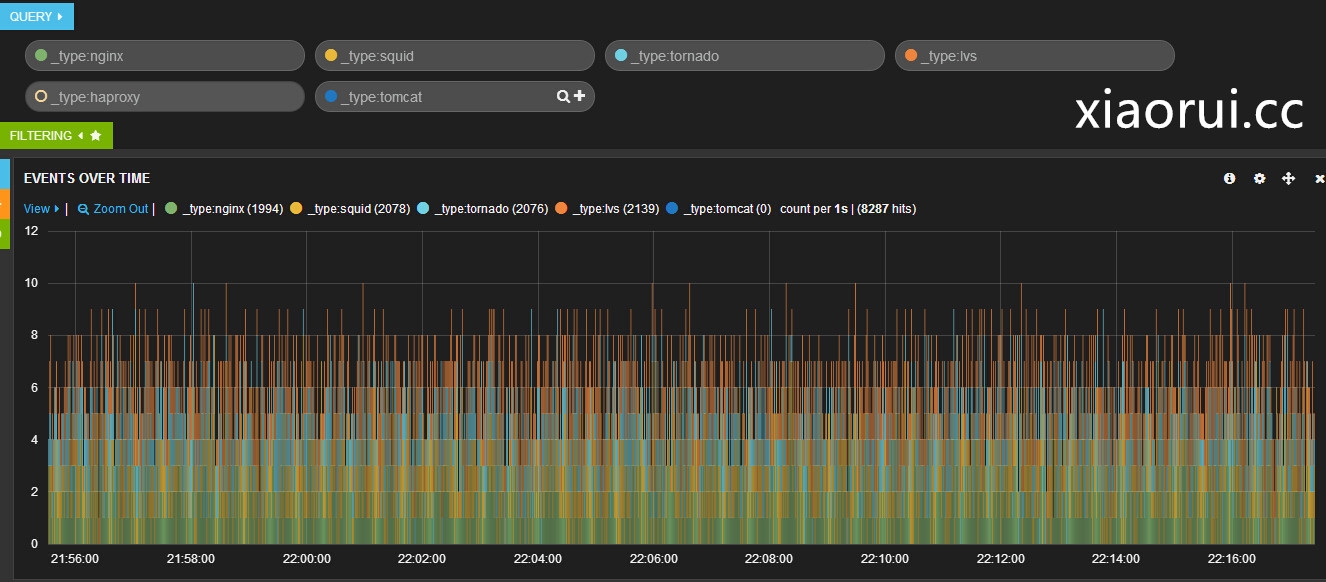

如果懒得写前端和数据接口,完全可以把日志和数据放到elasticsearch处理。我的开发主要是python,用pyes,只需要把数据扔给elasticsearch就行了。 格式是json的样子,看下面,用kibana可以做多条件的查询,我想搜 nginx,squid,tornado的类型,类型,出错的频率。

除了query,还有用regexp正则的方式

(111|222)

aaa.*

a{3}b{3} # match

a{2,4}b{2,4} # match

a{2,}b{2,} # match

.{3}.{3} # match

a{4}b{4} # no match

a{4,6}b{4,6} # no match

a{4,}b{4,} # no match

(ab)+ # match

ab(ab)+ # match

(..)+ # match

(...)+ # no match

(ab)* # match

abab(ab)? # match

ab(ab)? # no match

(ab){3} # match

(ab){1,2} # no match

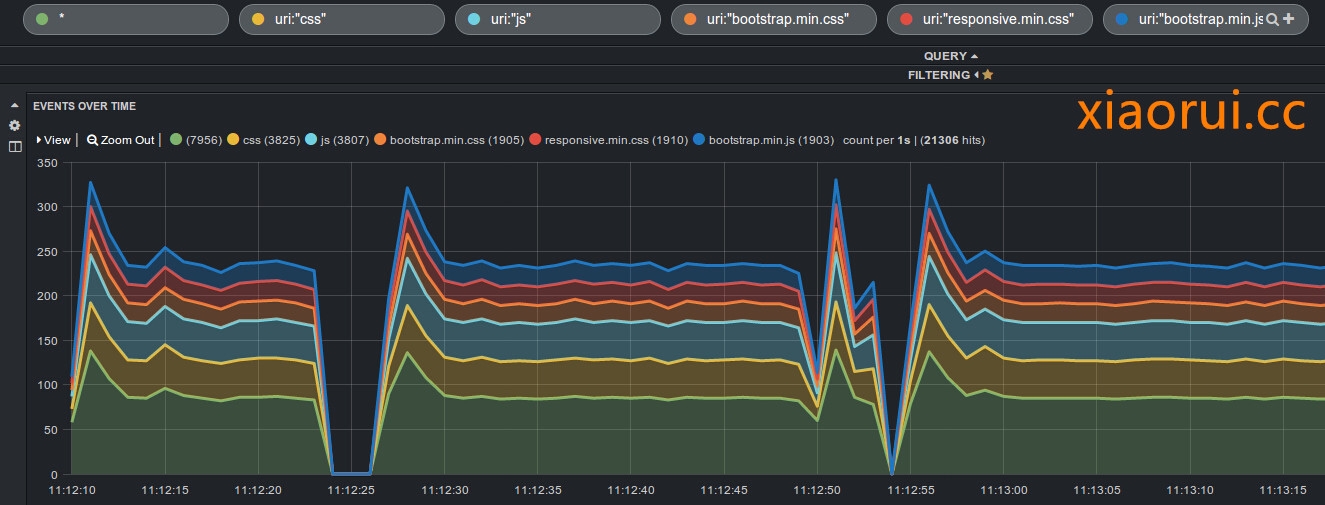

查询,web的日志,看下css,js,jpg,bootstrap.css,bootstrap.js 访问的一些比率 ~